| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |

- 레이텍

- 논문리뷰

- 이상 탐지

- Machine Learning

- 논문 리뷰

- anomalydetection

- 뉴럴네트워크

- Bagging

- Wavelet Transform

- Snn

- ae

- 인공신경망

- Deep Neural Network

- Python

- Spiking Neural Network

- MNIST

- 머신러닝 논문리뷰

- ML

- Fast Fourer Transform

- MLE

- Generative Model

- 기계학습

- 논문 해석

- autoencoder

- map

- 딥러닝

- Deep Learning

- 머신러닝

- 이상 현상 탐지

- rnn

- Today

- Total

목록Machine Learning (16)

MATH & ML

Generative model과 Discriminate model 차이점과 비교

Generative model과 Discriminate model 차이점과 비교

항상 공부를 하다보면 각 모델이나 방식마다 Generative model과 Discriminate model이라는 말이 나오면 항상 어려웠고 너무 헷갈렸기에 이를 내가 다시 이해해본 그대로 정리해보려고 한다. (출처 : http://sens.tistory.com/408) Generative model과 Discriminate model는 위키에 따르면 classification 경우에 정의를 한다. classification을 하는 경우 위의 사진처럼 각 x 데이터마다 label된 class y가 있을 것이고, 목적은 P(YlX)를 최대화 하는 Y를 찾는 것, 즉 새로운 X에 대하여 그 X가 어느 Y 클래스로 분류될 가능성이 큰지이다. 즉 X라는 데이터가 주어졌을 때의 파라미터의 함수, 즉 posteri..

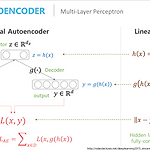

Autoencoder란 개략적 설명과 종류

Autoencoder란 개략적 설명과 종류

Autoencoder는 dimensionality reduction이면서 동시에 non-parametric Density Estimation인데기존의 dimensionality reduction과의 차이 & 기존의 density estimation과의 차이는바로 기존의 방법들이 Nerighborhood based training인데 이 Neighborhood기반의 방법들은 '고차원에서 가까운 애들은 왠만하면 manifold(저차원)에서도 가까울꺼야'라는 가정하에 진행한다. 하지만 고차원일수록 manifold를 잘 찾지 못하면 그 고차원에서의 거리는 실제 우리가 생각하는 거리와 다를 수 있다! 이것이 기존의 방법들과 autoencoder의 차이이다.2000년 초반쯤에 나온 autoencoder는 Deep ..

앞에 썻던 글에서 처럼 네이버 d2 영상을 보다보면 차원축소와 관련된 영상을 볼 수 있는데이에서 언급한 새로들은 차원축소와 관련된 관점들을 써보려고한다.0. 차원축소란 고차원에 존재하는 데이터들을 잘 담고(포함?어우르고?)있는 그 고차원에 있는 submanifold(저차원)를 찾는 것이라고도 볼 수 있다. 1. 차원축소가 필요한 이유 중 visualization도 물론 있지만, 고차원에서의 데이터들은 차원이 높은곳에 있어 데이터들이 너무 희박하게 존재해서 문제이다. 예를들면 그림 rgb 200*200 그림을 보면 랜덤으로 아무거나 뽑으면 거의 절대로 우리가 알아볼수 있는 그림이 나오기가 힘들다. 즉 Random image is just noisy일 뿐이다.2. 차원의 저주 : 같은 메져에 대해서도 고차원..

머신러닝의 전반적인 흐름(에러 관점, 확률론적인 관점 그리고 MLE와 MAP차이 및 연관성)

머신러닝의 전반적인 흐름(에러 관점, 확률론적인 관점 그리고 MLE와 MAP차이 및 연관성)

네이버 d2에서 이활석님께서 아주아주 최근에 발표하신 영상과 슬라이드를 공유해 놓으셨다.(링크는 맨아래)목적은 autoencoder를 설명하기 위함인데 이를 위해 초반부분에 deep Neural Network와 관련된 기초적인 내용을 먼저 설명해주셨는데영상을 보면 볼수록 설명을 쉽게 정리잘되게 해주셔서!머신러닝의 전반적인 내용을 이곳저곳 찾아보고 영상도 보며 큰 그림을 정리해보려 한다. 먼저 머신러닝에서 하는 건 큰 그림으로 볼때 다음 사진처럼 정리 할 수 있다.데이터가 주어지면 그걸로 어떤 알고리즘, 즉 모델을 학습하고, 이제 그 학습된 모델을 실제 정답의 모델과 거의 미슷하다고 가정하고 거기에 test data를 넣어서 나온 결과가 우리가 원하는 결과이다. (보니까 이건 supervised learn..

기존의 cnn의 문제점을 개선하여 나온 새로운 모델.cnn은 마지막 layer로 갈수록 더 복잡한 특징들(complex feature)을 나타내게 되는데 이는 단순히 이전 낮은 layer들의 가중치합을 이용하였다. 이러한 합은 기존의 simple feature와 complex feature사이의 위치관계를 전혀 고려하지 않아 문제가 된다. 예를들어 사람얼굴을 인식할 때에 사람눈이 이마에 2개 붙어있는 얼굴도 얼굴로 인식한다는 것이 문제이다.cnn에서는 이 문제를 해결하기위해 max pooling이라는 방법을 사용하여 size를 줄여주면서 높은 layer의 시야를 넓혀 줌으로서 공간적인 정보들까지 얻을 수 있도록 했다.하지만 힌튼은 맥스 풀링이 invariance를 보존 할 뿐 우리가 필요한 equivar..